ホロラボ武仙(@takesenit)です。

ATL-MRイベントシステムについて、2回目のアップデートをお送りします。 ブログでタイムリーにお送りしようと思ってたんですが、開発のスピードの方が執筆を遥かに上回っていますので後追いになっちゃってますw

前回、リクルートテクノロジーズ・アドバンスドテクノロジーラボ(ATL)さんとご一緒に企画開発してるMRイベントシステムの開発経緯などをプロトタイプの動画を使ってご紹介しました。

第1回: 「ATL-MR」とMRイベントシステム https://blog.hololab.co.jp/entry/2018/10/04/175300

Mixed Realityとのことで現実とデジタルが混在する不思議な体験を前回はちょっとだけ映像でご紹介しましたが、今回はちょっと細かく、主としてVR側での動作イメージを動画でお送りします。

- ATL-MR Event System - Status02 (デザイニウムYoutubeチャンネル)

ビデオの最初はログイン画面。Twitterのアカウント名を入力するとアイコンを流用します。また、VR側で表示されるアバターを選択。「Start」アイコンを選択すると、目の前にはVR空間に再現されたホロラボオフィスの光景が広がります。

前回の動画ではCADデータそのまま色を付けただけの真緑だったホロラボオフィスの各所にそれっぽいテクスチャが貼られたり、本物っぽい家具が配置されたりでかなりリアルに再現されました。積みあがったデバイスのダンボールまで再現されちゃってますww

現時点で、対応VR機器はHTC VIVEとOculus Goの2種類。もともとVIVE向けをメインで開発していたのですが、機器の価格と普及台数からOculus Goでも動くようにマイナーチェンジする形で対応しています。

動画前半はHTC VIVEでの動作イメージ。コントローラーのUIがリッチなので慣れると使いやすいです。

左手のコントローラーには2Dベースのナビゲーション。Mixed Realityな空間のどこにだれがいるかがアイコンで 表示されていたり、音声コミュニケーションのエリア分け(VOIP Area)が一目瞭然。

移動は右手コントローラーのトリガを使ったワープ。VRは動かなくてもVR空間で移動できるのがラクでいいですよねw

当初はワープ移動だけで、向きを変えるには自分が頭を回さなければいけなかったのですが、先日実施したテストでATLの担当さんからアドバイスを頂いて、ワープ移動だけでなく回転もコントローラーで実施出来るように現在改良を加えているところです。

VR空間と実空間との間でのコミュニケーションをどのようにうまく実施するかを考えて、現状は音声と、アイコンなど記号化されたコミュニケーションを主軸において開発をしています。

コミュニケーションを取りたい相手のアバターやアイコンをコントローラーで狙って、「Hello!」や「後で話しよう」などの定型テキストメッセージが送信出来たり、自分の周りに感情を表現するアイコンを出したりが出来ます。

また、VIVEはコンピューティングリソースもリッチなので、同時に俯瞰映像を外部出力したりも可能。

Mixed Realityなイベント会場がどんな雰囲気なのか、誰がどこでどんな感情でイベントに参加してるのかを見ることが出来ます。

動画の真ん中あたりのSide by Sideの映像はOculus Goの画面。基本動作と機能はVIVEと同じなのですが、コントローラーが1台だけなので若干使い方が異なります。

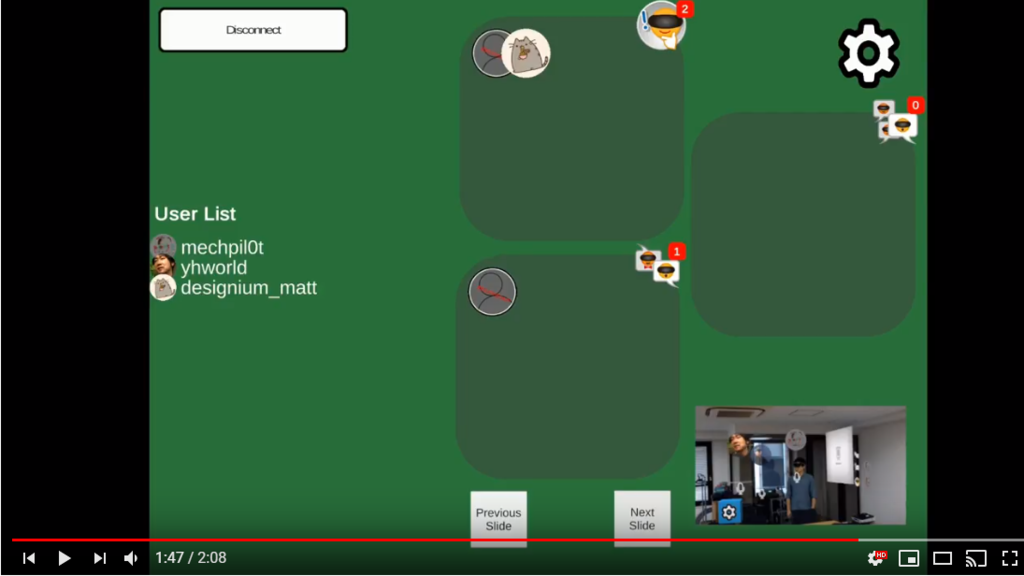

最後の方は、Androidベースで開発された管理画面の動作イメージ。

これはリアルなイベント会場でHoloLensを被った登壇者が手にもって活用するイメージで、VIVE同様イベント会場全体の配置と、イベント会場各所に配置されたスライドそれぞれの内容に対するリアクションなどが閲覧可能。イベント参加者のリアクションに応じたプレゼンテーションなどが実施出来るよう開発しています。

次回第3回は、Mixed Realityイベント体験を快適なものに出来るよう開発している細かな機能についてご紹介します!