Apple iPad/iPhone搭載「LiDARスキャナ」について調べてはじめてみたら分量がとんでもないことになってきたのが前回。

さて、もとの記事AppleがII-VI(ツーシック)へ440億円を拠出した話題に戻って考えると、

「LiDARのサプライヤー」って言った場合に、このLiDARの構成部品のうちのどのサプライヤーなのかが気になった、ということでしたw 細かくてすみませんw 一応、ホロラボを作る前に半導体商社で光半導体なども扱っていたりで、この辺も関心の深いところでしてw

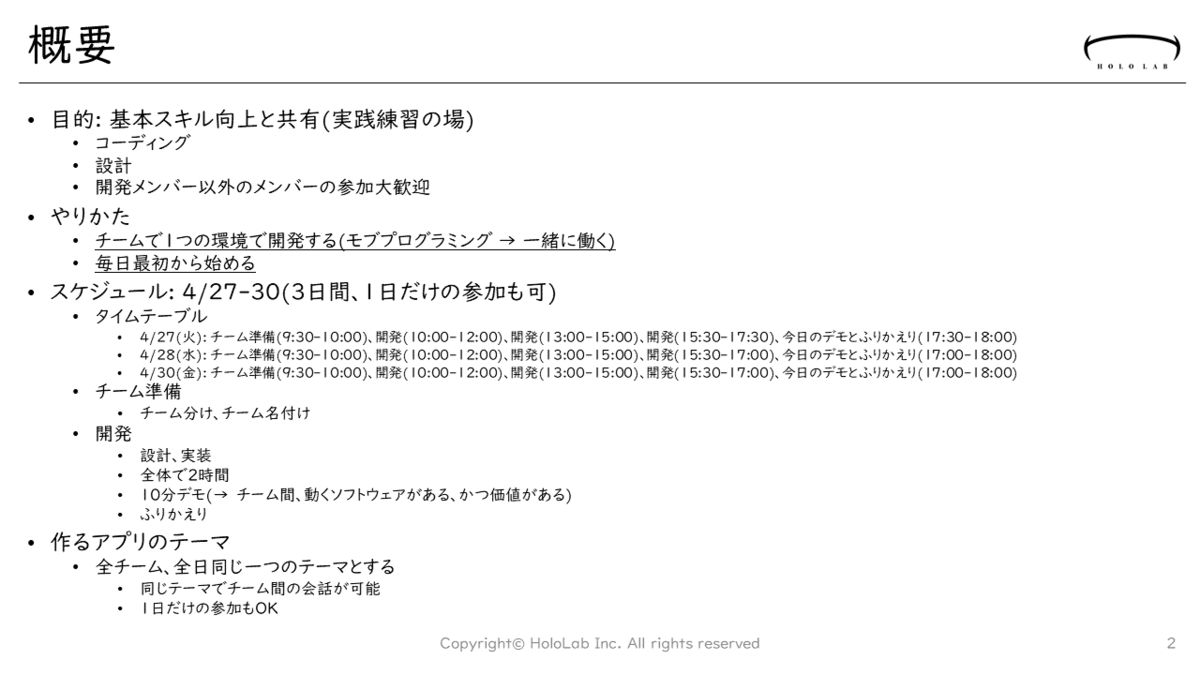

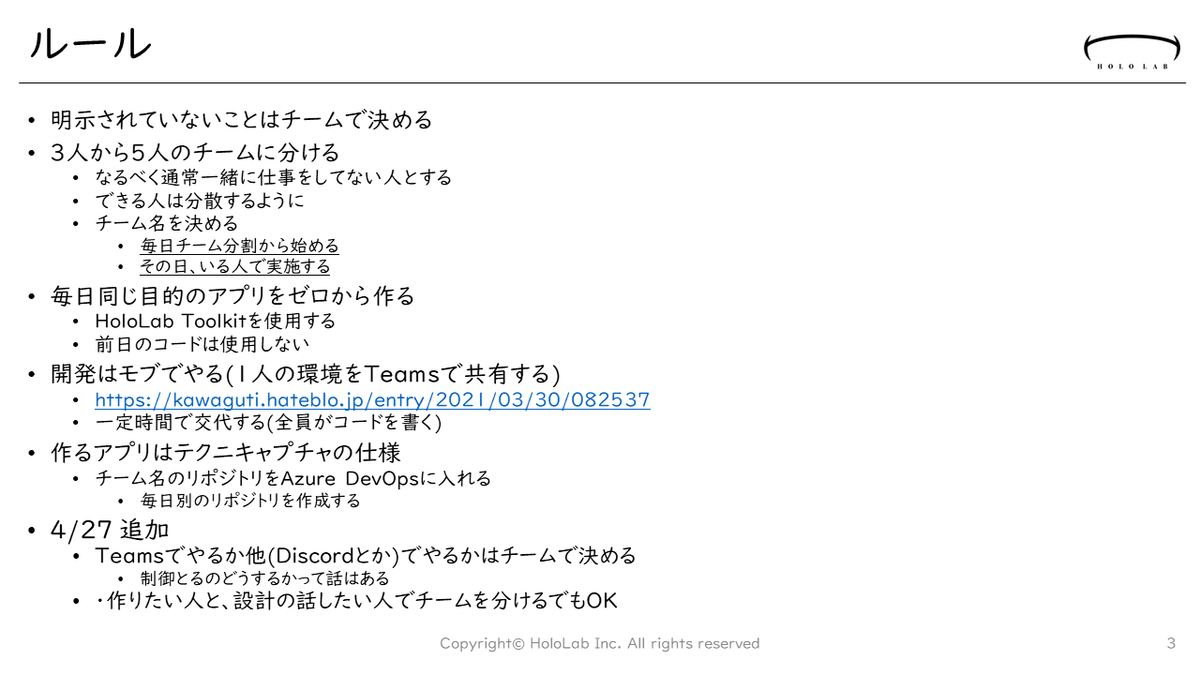

Apple製品におけるLiDARの構成について

2021/5の現段階において、Apple製品でLiDARが搭載されてるのが下記の大きく2製品3タイプ。

- 2020 - iPad Pro (A12 Bionic)、iPhone 12 Pro/Max (A14 Bionic)

- 2021 - iPad Pro (M1)

iPadって、ディスプレイのインチ数が異なると世代が違うので第〇世代ってシンプルに言えない状態なんですねw

まだiPhoneや最新M1 iPad Proの中身に関する情報は多くないので基本は2020年版iPad Pro搭載のLiDARについてですが、こんな資料があったので引用します。

Apple、iPad/iPhoneの裏面に搭載されてる「LiDAR」の中身で今まで詳しいチラシが。

— Takesen - 武仙@一緒にMixed Realityやろうぜ!(採用拡大中) (@takesenit) 2021年5月8日

dToF方式のLiDARモジュールの中身は下記の構成とサプライヤ名。

VCSEL(発光素子) - Lumentumhttps://t.co/QI3Fbh5YSj

SPAD (受光素子) - Sony

DOE (光学素子) - Himax

Source: https://t.co/wTrLp02iou

System Plus社のTierdownレポートのブローシャ: https://www.systemplus.fr/wp-content/uploads/2020/06/SP20557-Apple-iPad-pro-Lidar-Module_flyer.pdf

こちらのレポート(のカタログ)によれば、主要部品は下記とのこと。

- 発光素子 (VCSEL) - Lumentum社(US) https://lumentum.com/en

- 受光素子 (SPAD) - ソニー(日本) (ソニーセミコン・I&Sテクノロジーページリンク)

- 光学素子 (DOE) ‐ Himax(台湾) (Himax Technologies - WLOページリンク)

このVCSEL、SPAD、DOEのそれぞれがどんなものなのかについてや、AppleのLiDARスキャナで初めてこのサイズで実装されたdToF方式(direct Time of Flight)については、日系XTECHの記事がかなり詳しくまとまってます。関心のある人はぜひご参照ください。(要サブスク登録)

Appleの「LiDAR」の仕組み、dToF(direct Time of Flight)について日経XTECHの記事が詳しい。(登録者向)

— Takesen - 武仙@一緒にMixed Realityやろうぜ!(採用拡大中) (@takesenit) 2021年5月8日

このVCSEL、SPAD、DOEというOptoelectronics技術の組み合わせであの変態な性能の3Dスキャナがスマホの物理/電気フットプリントに載ることになったのが良く分かります。https://t.co/ruvLvsIxdf

VCSELって何?

今回このブログでまず注目したいのがVCSEL、ヒカリモノの方です。たしか940nmぐらいのNIRなので肉眼では見えないけれどw

このVCSEL(ビクセル)は光デバイス、半導体レーザーの一種ですが、良い感じの特徴があるので武仙もなぜか前職から気になって覚えてました。

VCSELはVertical Cavity Surface Emitting Laserのアクロニム、頭文字語で、日本語だと「垂直共振器型面発光レーザ」と訳されます。

VCSEL-Vertical Cavity Surface Emitting Laserは垂直共振器型面発光レーザと訳されます。ここでのCavityは英語だと「穴」っていう意味合いもありますが、光を閉じ込めて何度も往復させて増幅する「光共振器」っていう意味合いらしい。共振器が垂直に配置されてるってこと。https://t.co/jHmgiVM9cK pic.twitter.com/6ciFbrLTwr

— Takesen - 武仙@一緒にMixed Realityやろうぜ!(採用拡大中) (@takesenit) 2021年5月8日

こちらのTweetでの「Cavity」の意味合いに関してSATOMIさんからコメントを頂いてまして、半導体レーザーでは共振(resonance)しつつ発振させるので「共・発振器」の意味合いがあるとのこと。めっちゃ勉強になる。Twitter最高。そして「穴」って覚えててすみませんw

昔々、電通大のレーザー研に居たのですが、普通のレーザーのCavityは発振器と訳していて、半導体レーザーでは、Cavity長をレーザーの波長の整数倍に設計して共振(resonance)も利用して発振効率を上げるので、共・発信器が近いがいねんかも知れません。

— Mitsunori SATOMI (@gravitino) 2021年5月8日

LED/VCSEL/LASERを比べてみる

このビビビビクセル、VCSELがどういう特徴を持ってるか分かりやすい図を探したのがこちら。同じヒカリモノデバイスのLEDと、あとはいわゆる普通のレーザーとの構造的な比較。

参照元: The FOA Reference For Fiber Optics - Fiber Optic Transmitter Sources-Lasers and LEDs

この図がめっちゃ分かりやすくて好きです。それぞれ、発光面、共・発振器の配置について書いてみる。(ここでのLASERは気体レーザーなどではなく半導体レーザー、Laser Diodeについて書いてます。)

- LED: Light Emitting Diode 面発光、共振器を持たない

- VCSEL: Vertical Cavity Surface Emitting Laser 面発光、共振器が垂直配置

- LASER: Light Amplification by Stimulated Emission of Radiation 端面発光、共振器が水平配置

ここはちょっと自信のない部分で武仙の理解を書きます。間違ってたらツッコミお願いしますw

LASERとVCSELはいずれも共振構造を持っていて、エネルギーを共振させて位相の単一な(Coherent: コヒーレントというらしい)「レーザー光」を生成できます。このレーザー光は波長が急峻で高い直進性が特徴。

LEDはそもそもこの共振構造を持たずに、pn接合のバンドギャップから生まれる光エネルギーをボヤっと大き目の開口から出すw

底面は鏡面構造になってたりと発生した光をなるべく表面から出すようなデザインになってるんですが、位相がバラバラなので減衰しやすい。

波長がLASERから比べれば幅広いし、開口が広く拡散するからボヤっと光る。

それでもってVCSELは、ちょうどLASERとLEDの良いところ取りを狙ったデバイス構造。もともと先にLASERが産まれて、その後に半導体加工技術が向上した結果、共振部を垂直配置して、LED的な低電力でもレーザー光が得られるように出来たもの、、、って理解しています。

ってことで、VCSELも面発光な点はLEDと一緒ですが、Cavityで増幅された光が狭い開口から射出されるため指向性が高く遠くまで光が届く。それでいて端面発光なレーザーより圧倒的に低消費電力化が可能。

なんとこのVCSELは、日本の人が発明。知らなかった。 https://jstage.jst.go.jp/article/lsj/37/9/37_649/_pdf

1977年に伊賀健一博士(現東京工業大学長)により発案

なんだか、ちょっとうれしいw

VCSELによるアレイ化

ただこのVCSELの出す光もレーザーと同じく開口径も狭くて直進性が高いので、LiDARとして使ったとしても遠くまで届きますがそのままでは2D/3Dに距離計測が出来ません。

そのため、Appleが採用しているLiDARではいくつか指向角を広くしたり3Dにするための手法が採用されている模様です。第一回で書いた「Solid Stateで3Dにする方法」で言うと、 1) レーザーを複数にしてラインスキャン状態にする、と3) 光学的に3D LiDARにする、が採られています。

端面を切断してそこから光を取り出すLASERと異なり、VCSELはLEDと同様に、一つの半導体ウェハ上にアレイ配置が可能です。

VCSELが(端面発光)レーザーと比較してもう一つ大きな特徴が、アレイ化が容易な点。

— Takesen - 武仙@一緒にMixed Realityやろうぜ!(採用拡大中) (@takesenit) 2021年5月8日

日経XTECH記事によるとiPad Pro(2020)搭載LiDARモジュールのVCSELも4x16、計64個のアレイ形状。

> VCSELの光源の4つがひとかたまりになって電極につながり、それが16列並んでいた。つまり、合計64点あった pic.twitter.com/cpSHpBhahQ

日経XTECH記事によると、AppleのiPad Pro(2020)搭載LiDARスキャナモジュールにおいてもVCSEL素子は4x16、計64個のアレイ形状と判明しています。

VCSELの光源の4つがひとかたまりになって電極につながり、それが16列並んでいた。つまり、合計64点あった

DOEにより、アレイ状のレーザー光を更に拡散

今度は「Solid Stateで3Dにする方法」における、3) 光学的に3D LiDARにする、手法で更に広い範囲にレーザー光をバラ撒いてます。

iPad Pro(2020)搭載LiDARスキャナでは、この64個のVCSELアレイの光源を回折光学素子(DOE: Diffractive Optical Element)で、9つに分散させてバラまいてる様子が日経XTECH記事で説明されてます。(ぜひ本文を契約して読んでねw

DOEは光波が持つ回折(かいせつ)効果と、その効果を持つ格子状の構造体からなる光学部品。波状の光をスリットを通して回り込ませつつ波頭の集まる場所を集約することで任意の形に光の方向をコントロール出来ます。

LiDARスキャナの中ではDOEを使って、レーザーアレイの直進光を9つに分岐させています。レーザーの指向性の関係で照射範囲が点だったものを、VCSELをアレイ化して2D面にして、更に光学素子で拡散していると考えられます。

iPad Pro(2020)搭載LiDARモジュールでは、更にこの64個のVCSELアレイの光源を回折光学素子(DOE: Diffractive Optical Element)で9つに分散させてバラまいてる様子が日経XTECH記事で説明されてます。(ぜひ本文読んでねw

— Takesen - 武仙@一緒にMixed Realityやろうぜ!(採用拡大中) (@takesenit) 2021年5月8日

レーザーの指向性の関係で照射範囲が狭いのを光学素子で補ってる感じか。 pic.twitter.com/Ae65YMgSvg

この拡散によって比較的広い範囲にLiDARスキャナの光源を照射出来てるのが分かりますね。

VCSELとDOEによってばら撒かれたレーザー光はLiDARモジュールから放射状に広がっていきます。距離が延びればそれだけ照射範囲も広くなりますが、今度はVCSELの光が減衰するので、おおよそ信頼のおける測距結果が得られるのが5メートル程度。それぐらいの距離をこのドットパターンで覆うと、ちょうど人間の視野をカバーするぐらいになりそう。

手に持つにしても、メガネのように着用するにしても、AR利用を考えた設計になってる気がしますね。

さて、連載はまだ続きます。(次回リンク)

ホロラボではLiDARスキャナを使ったiOSアプリも開発しています。

開発のお問い合わせはこちら。

https://hololab.co.jp/#contact

また、ARKitやLiDARを使ったiOSアプリ開発者も激しく募集しています! hololab.co.jp

面白そうだなと思って頂けたら、ぜひお気軽にお問い合わせください!